布斯导读

在人工智能被广泛应用于商业决策的当下,你是否也在思考,模型的训练数据,究竟来自哪里?如何能让它们更专业、更可靠?芝加哥大学布斯商学院的最新研究聚焦于数据质量对AI表现的影响,为特定行业的AI模型优化提供了新的可能。

如果你发现你的理财顾问通过浏览社交媒体平台上的帖子来接受培训,你还会信任她给出的建议吗?其实,当我们依赖由ChatGPT-4和Claude 3.5 Sonnet等大语言模型(LLM)构建的金融模型时,我们某种程度上也是在做同样的事。这类模型通常预先通过庞大而多元的通用数据集来进行训练,例如Common Crawl——该语料库的信息收录了数十亿个网页的信息,其中既包括知识,同时也不可避免地夹杂着虚假信息与偏见。当这些模型进一步被训练为能够生成人类所需内容的工具时,它们的训练数据也依旧以网络信息为主。

对此,芝加哥大学布斯商学院研究人员Siyan Wang和Bradford Levy教授提出了一种全新的方法,以削减LLM中的偏见,并将LLM锚定在与投资决策相关的内容上。他们创建了一个以商业为导向的大型数据集BeanCounter,其数据来自公司财报和企业信息披露文件。这些文件是企业必须依法准确申报的内容,且需要接受监管审核,一旦造假可能会面临法律责任。研究人员表示,这意味着这些文件作为训练人工智能的基础数据会更加可靠,从而能够让金融LLM生成的内容更为精准,也会大大降低出现有害信息的可能性。

据研究人员介绍,BeanCounter是他们所知范围内最大、最全面的商业文本数据集。数据集的体量通常以“tokens”(词元)衡量,即模型学习所依赖的单词与短语片段。BeanCounter包含了1590亿个词元。相比之下,Common Crawl的原始数据虽然超过100万亿词元,但经过去重处理后,实际用于训练的仅剩不到15万亿。

为构建BeanCounter,研究人员从美国证券交易委员会(SEC)的EDGAR数据库中收集了数百万份公开文件,该数据库的历史可以追溯至1996年。这些文件包括年度报告(10-K)、季度报告(10-Q)及其他所有公司依法需披露的材料。

高质量训练数据带来的影响

芝加哥大学布斯商学院的此项研究表明,通过使用BeanCounter这一大规模数据集进行训练,模型在金融相关任务上的表现得到了显著提升。

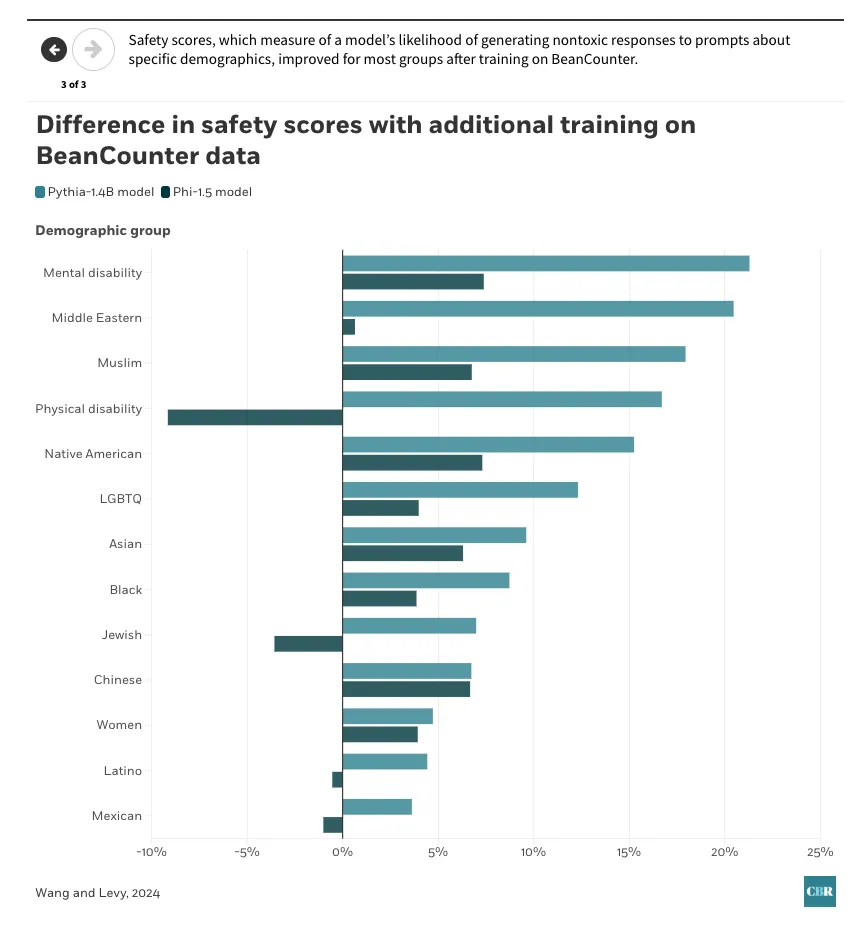

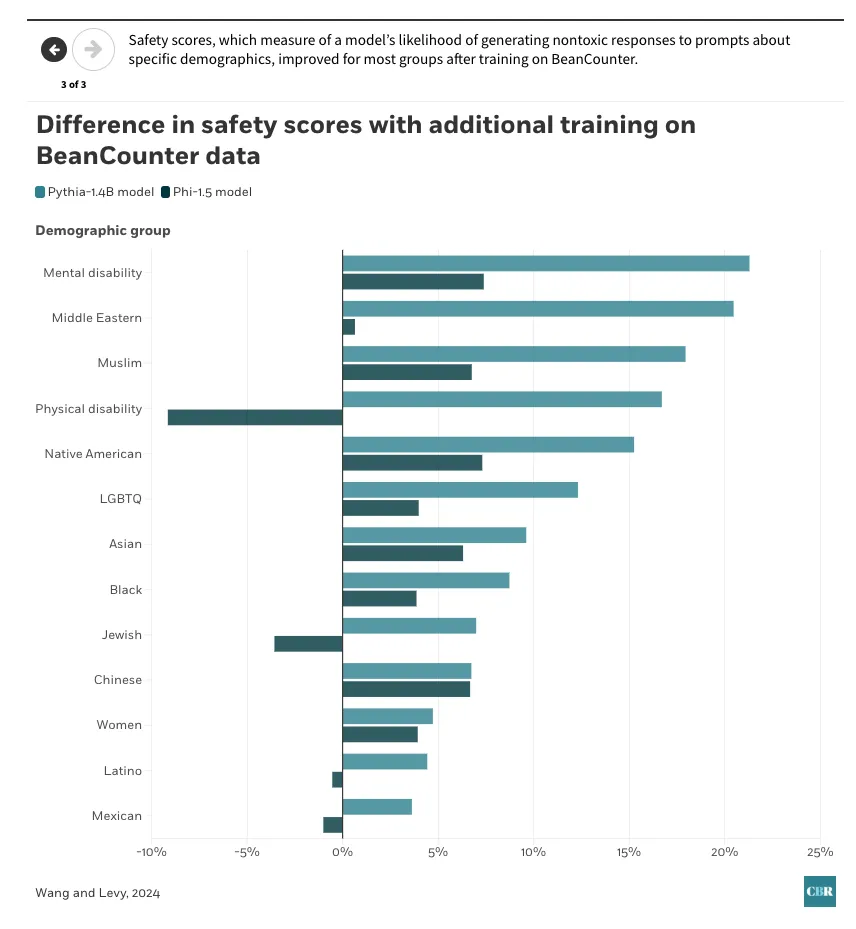

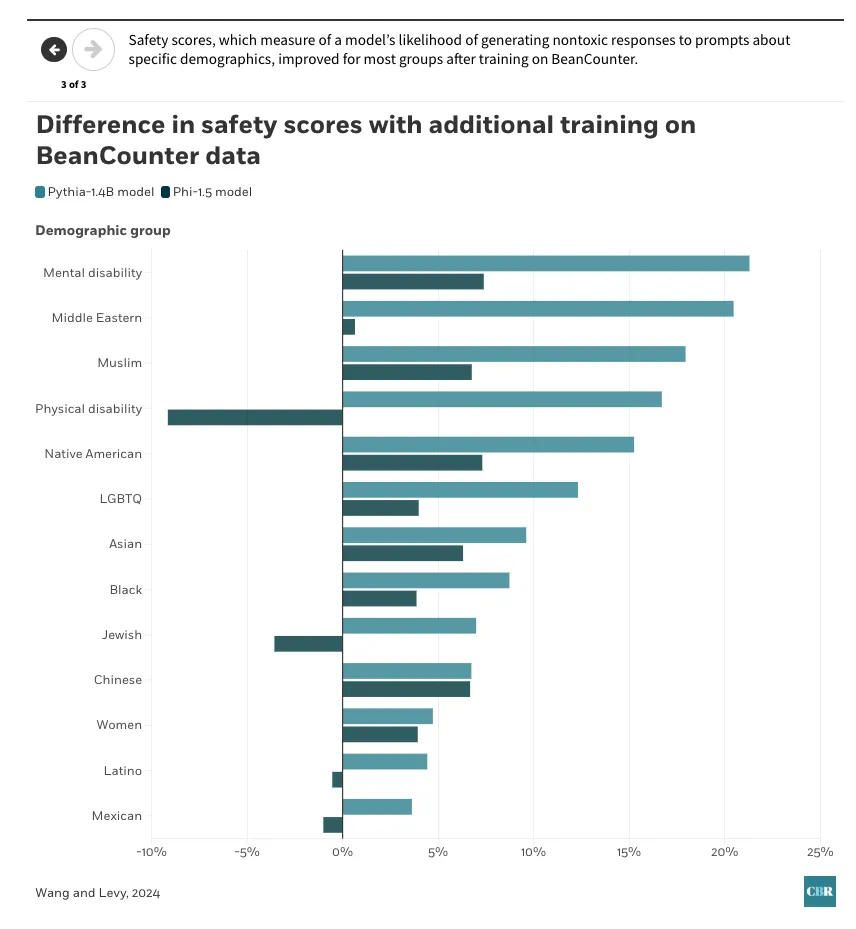

研究也表明,在BeanCounter数据的进一步训练下,模型生成有害信息的可能性有所降低。

“安全评分”(safety scores)用于衡量模型在回应有关特定群体的指令时,生成无害回答的可能性。在使用BeanCounter进行训练后,大多数群体的安全评分均得到了提升。

研究人员对文本数据进行了提取和清洗,去除了重复和无关信息,最终形成了一个以专业书面语言呈现、真实可信的大规模语料库。他们表示,该语料库中仅有不到0.1%的内容出现在现有基于Common Crawl的数据集中,这代表着该数据集在AI训练领域几乎尚属未被开发的资源。

研究人员已通过机器学习模型、数据集和工具共享合作的线上平台Hugging Face Hub,将 BeanCounter向公众开放。由此,其他研究人员和机构也能够使用该数据集,共同推进更安全AI系统的开发。

为了衡量这一新数据集对企业的实际价值,Wang与Levy围绕两个金融任务开展了实验:命名实体识别(NER)和金融短语库(Financial PhraseBank)情绪分类。NER用于识别和分类文本中的关键信息,包括人名、时间、地点等,例如识别“apple”一词是指科技公司Apple还是水果、确认公司总部是否位于Cupertino。而金融短语库任务涵盖近5000条金融新闻句子——根据可能对股价产生的影响,它们被分别标记为“积极”、“中性”或“消极”。

研究人员利用BeanCounter数据对两个现有的小型AI模型进行了“持续预训练”(即在已有预训练基础上,继续使用领域专属数据提升特定任务表现),这两个模型分别是EleutherAI发布的Pythia-1.4B和微软的Phi-1.5。他们将这些预训练后的模型与未使用BeanCounter数据的原始版本进行了对比,前者表现出的优势非常突出:使用BeanCounter继续训练的模型生成有害内容的概率下降了18%至33%,而在NER与金融短语识别任务上的表现则提升了约4%。

Wang和Levy还分析了BeanCounter中对各类人群的呈现方式。他们发现,BeanCounter文档中提及这些群体的频率与Common Crawl相当,但语言明显更为中性和专业。例如,“Asian”一词在BeanCounter中的相关表述,其平均“毒性”(toxicity,指不当表达)较网络内容低约72%。研究人员使用了一种先进的有害语言识别工具Perspective来衡量文本的“毒性”,而在几乎所有被分析的人口分类标签中,这种“更温和的表达”现象都得到了验证。研究指出,这表明BeanCounter所依赖的文本素材更具专业性和分寸感,即便是在涉及敏感话题时亦是如此。

Levy表示,BeanCounter可以作为对现有数据源的补充。其规模已经足以单独支持像OpenAI GPT-4o mini这样的模型进行预训练。虽然它尚不足以单独训练参数高达4050亿的Meta大型LLaMA模型,但在Meta的预训练流程中,尤其是在通过高质量长文本优化模型表现的“退火阶段”,它依然具备重要价值。

Levy还指出,BeanCounter亦可作为评估LLM表现的工具。由于其数据基于真实商业信息,且配有明确时间戳,因此可以判断一个模型的回答不仅是否准确,还是否在特定时间点上具备现实相关性。

随着AI日益融入各行各业的决策流程,高质量、可信赖的训练数据将变得愈发重要。正如Wang和Levy所言,BeanCounter的案例表明,经过精心设计的领域专属数据集不仅能提升模型性能,也能帮助AI系统更符合伦理标准。这为其他需要高度准确性与专业性的领域(如法律或医学)开发专用AI模型提供了可行路径。

研究人员预测,在未来,AI系统将不再主要从社交媒体学习,而是转向专业信息源汲取知识,从而输出更可靠、更客观的洞察,同时在效率和成本上也将优于通用大模型。这就如同向专业理财顾问寻求建议,而不是依赖社交平台上的信息作出决策。

【广告】

(免责声明:此文内容为本网站刊发或转载企业宣传资讯,仅代表作者个人观点,与本网无关。仅供读者参考,并请自行核实相关内容。)